本课程属于从基础到应用实战性质的一个课程,主要介绍ZooKeeper+Kafka+ELK架构以及Filebeat及Logstash的各种应用插件具体用法。最后通过多个案例介绍了如何收集Apache、Nginx、Tomcat、Mysql、HDFS等日志收集与zabbix的整合告警、架构优化经验。

ELK是目前行业中非常热门的一个技术,它可以用于电商网站、门户网站、企业IT系统等各种场景下,也可以用于对海量的数据进行近实时的数据分析。

ELK呢,就是给运维提供辅助的一个应用套件。运维工作就是对各种业务系统进行监控,发现问题,能够及时告警,然后能够迅速查到问题,进而解决问题,这是运维工作的核心。而如果运维管理的服务器和业务系统非常多的情况下,可能无法及时、准确的了解每个业务系统和服务器的状态,如果发现业务系统有问题,那就需要登录业务系统服务器去查问题,但是如果服务器很多呢,有几百台、甚至更多情况下,不可能一个一个系统登录查看吧。

怎么解决这种问题呢,ELK这个套件工具,就可以解决这个问题,ELK是集中对日志进行收集、过滤、分析、可视化展示的工具。

通过ELK,将运维所有的服务器日志,业务系统日志都收集到一个平台下,然后提取想要的内容,比如错误信息,警告信息等,当过滤到这种信息,就马上告警,告警后,运维人员就能马上定位是哪台机器、哪个业务系统出现了问题,出现了什么问题,都会在ELK平台有详细的描述。

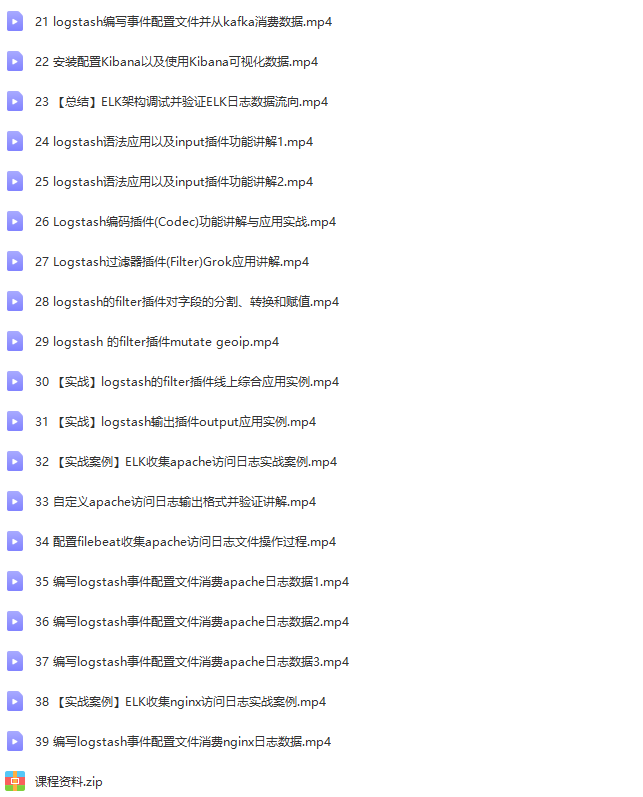

课程大纲:

1、ELK企业常见应用架构分享以及工作流程

2、zookeeper基础入门与集群架构模式

3、kafka基础入门以及Topic与Partition

4、kafka的消息发送、消费与存储机制详解

5、filebeat基础入门以及ELK常见企业应用架构

6、ELK+Filebeat+Kafka构建大数据日志分

7、elasticsearch集群架构以及JDK环境变量

8、elasticsearch集群构建并进行系统JVM调

9、elasticsearch集群配置以及常用参数介绍

10、【案例实战】安装与配置zookeeper集群过程1

11、【案例实战】安装与配置zookeeper集群过程2

12、安装与配置kafka集群的方法与注意事项

13、【案例实战】安装并配置kafka集群的全过程

14、kafka集群命令讲解创建topic 生产消息与消费

15、【案例实战】安装并配置filebeat及配置项介绍

16、启动filebeat并验证日志输出和日志格式说明

17、filebeat日志输出格式介绍和字段删减方法

18、logstash深入input filteroutp

19、logstash入门介绍以及日志输出格式解析1

20、logstash入门介绍以及日志输出格式解析2

21、logstash编写事件配置文件并从kafka消费数

22、安装配置Kibana以及使用Kibana可视化数据

23、【总结】ELK架构调试并验证ELK日志数据流向

24、logstash语法应用以及input插件功能讲解1

25、logstash语法应用以及input插件功能讲解2

26、Logstash编码插件(Codec)功能讲解与应用

27、Logstash过滤器插件(Filter)Grok应

28、logstash的filter插件对字段的分割、转换

29、logstash 的filter插件mutate g

30、【实战】logstash的filter插件线上综合应

31、【实战】logstash输出插件output应用实例

32、【实战案例】ELK收集apache访问日志实战案例

33、自定义apache访问日志输出格式并验证讲解

34、配置filebeat收集apache访问日志文件操作

35、编写logstash事件配置文件消费apache日志

36、编写logstash事件配置文件消费apache日志

37、编写logstash事件配置文件消费apache日志

38、【实战案例】ELK收集nginx访问日志实战案例

39、编写logstash事件配置文件消费nginx日志数

〖资源截图〗: